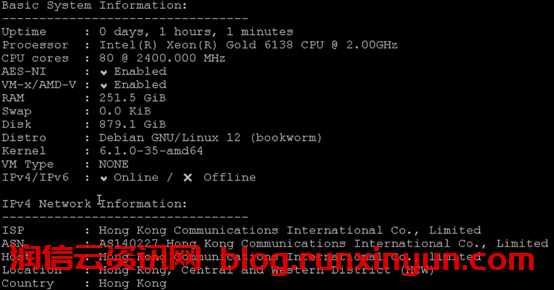

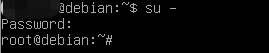

一、准备工作

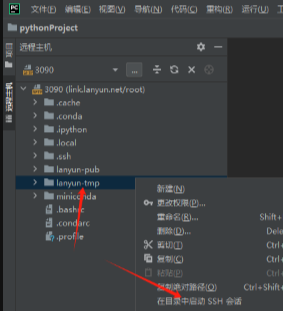

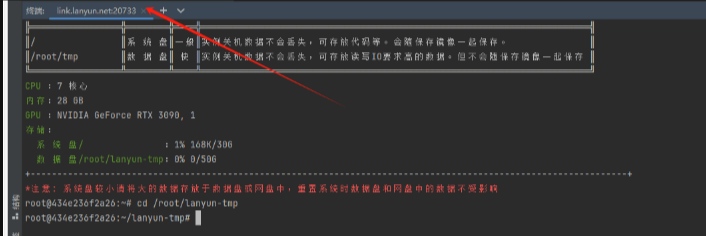

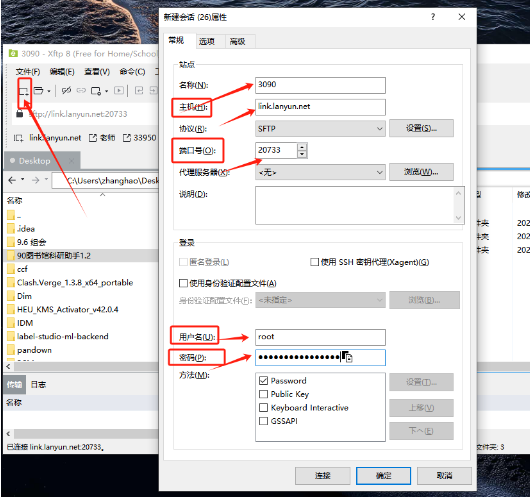

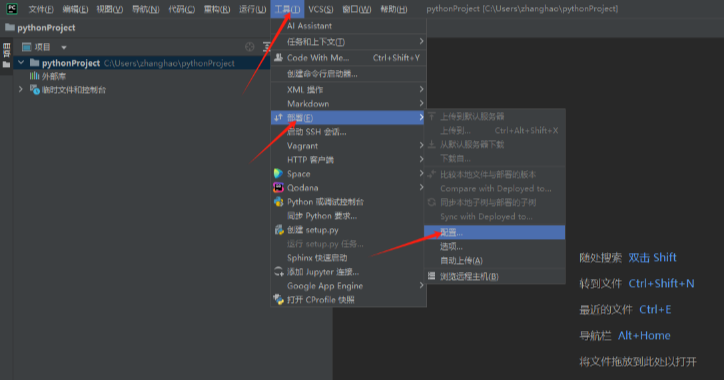

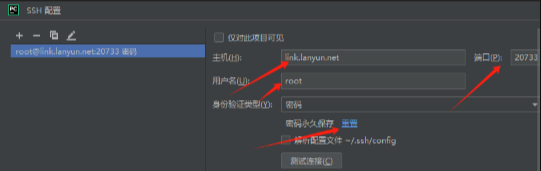

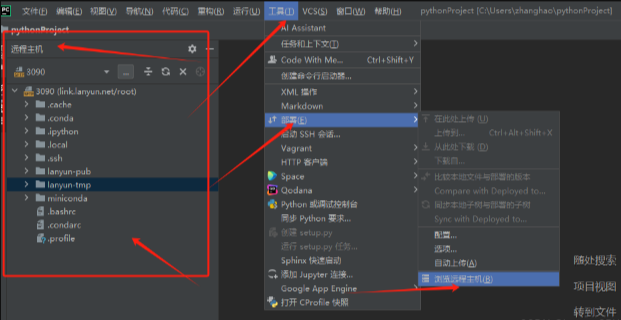

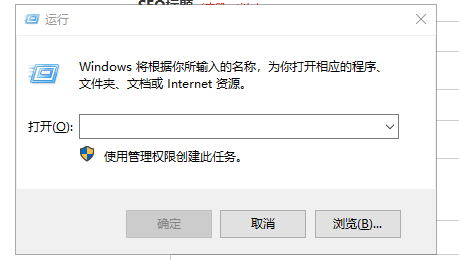

二、pycharm连接远程服务器方法

三、项目环境配置---RTDETR 和YOLO环境相同

conda create -n yolo python=3.8 #创建虚拟环境(云GPU若有对应环境可不用创建) conda init(可选) conda activate(可选) conda activate yolo #进入虚拟环境 #yolo可替换其他名字

以下代码装好虚拟环境后可直接全部复制进去,或者一条一条复制,一般不会出现报错情况。

(若网络下载过慢,可尝试切换其他镜像源)

pip install torch==1.13.1+cu117 torchvision==0.14.1+cu117 torchaudio==0.13.1 --extra-index-url https://download.pytorch.org/whl/cu117 -i https://pypi.tuna.tsinghua.edu.cn/simple pip install timm==0.9.8 thop efficientnet_pytorch==0.7.1 einops grad-cam==1.4.8 dill==0.3.6 albumentations==1.3.1 pytorch_wavelets==1.3.0 tidecv -i https://pypi.tuna.tsinghua.edu.cn/simple pip install -U openmim -i https://pypi.tuna.tsinghua.edu.cn/simple mim install mmengine -i https://pypi.tuna.tsinghua.edu.cn/simple mim install "mmcv>=2.1.0" -i https://pypi.tuna.tsinghua.edu.cn/simple apt-get update apt install libgl1-mesa-glx pip install psutil -i https://pypi.tuna.tsinghua.edu.cn/simple

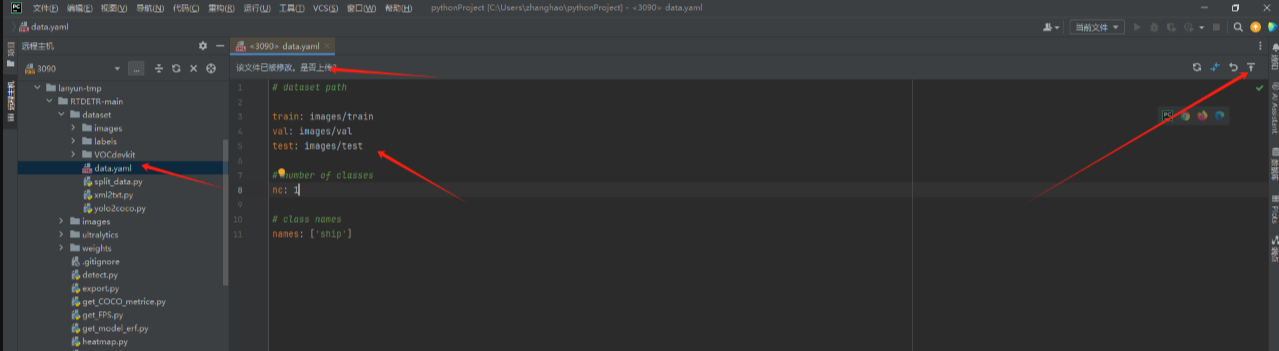

四、训练教程---RTDETR 和YOLO相同

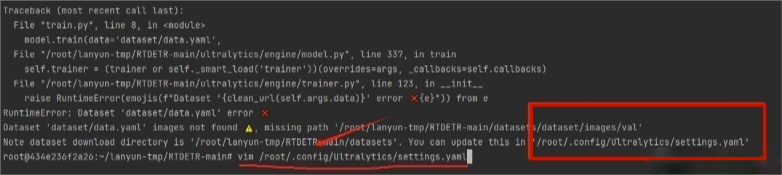

⑤vim /root/.config/Ultralytics/settings.yaml (---vim到上方报错路径)

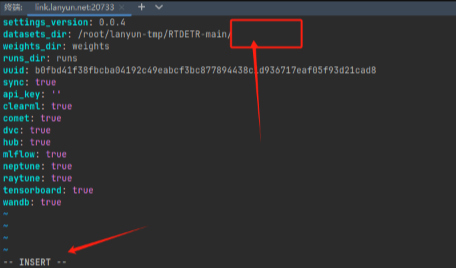

按键盘上的“i”键进入改写模式,删除路径后方的datasets,改成以下路径后按ESC退出改写模式后,按Shift+Z+Z保存代码退出

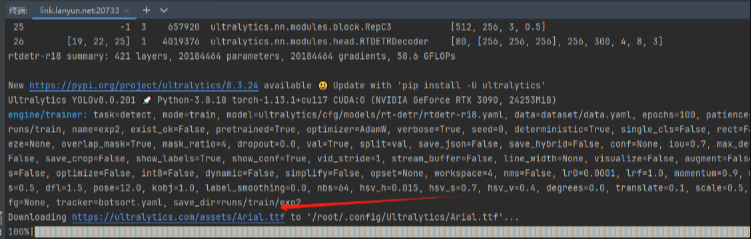

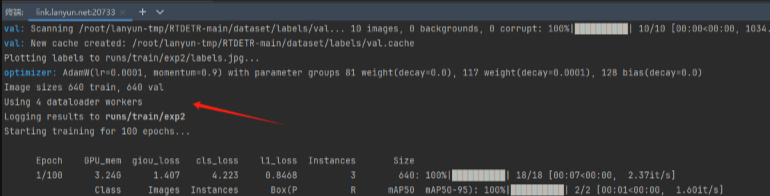

⑥再次运行python train.py 指令后成功运行,或者可能会出现字体下载卡顿

如出现以下卡顿情况,请点击下载链接在本地下载后上传到和train.py同级目录,然后在终端使用以下指令:即可解决该问题,

mv Arial.ttf /root/.config/Ultralytics/Arial.ttf

五、训练过程中的一些小技巧

1.使用nohup指令进行后台训练,防止因断网导致的中断等情况

①使用python train.py指令的话 你电脑网络环境发生变化时(则你的训练后中断,比如开关vpn,电脑息屏,网络不稳定)

②使用nohup python train-s.py > log.log 2>&1 指令的话,你跑通后电脑不管是关机还是啥,他代码都会在服务器后台跑,和自己电脑没关系)

nohup python train.py > log.log 2>&1 nohup python train-1.py > log1.log 2>&1 nohup python train-2.py > log2.log 2>&1 nohup python train-3.py > log3.log 2>&1 #----服务器训练代码请使用nohup指令在后台跑, 然后目录下会出现log.log的日志文件,存放你的所有打印的信息 以上默认为0卡跑,若存在多卡,请在指令前加 CUDA_VISIBLE_DEVICES=1 例如 CUDA_VISIBLE_DEVICES=1 nohup python train-s.py > log.log 2>&1 ......

2.查看是否跑完 nvidia-smi,//查看显存变化,如果跑一个实验占了8个G显存,然后显存变成0的时候就说明跑完了

3.查看跑到哪一轮了,精度是多少 查看runs/train/exp文件里面的result.csv,主要查看map50 和map50-95 的涨点情况

4.查看代码是否报错,打开日志log.log查看代码报错情况

5.运行一次代码,会出现一个进程号,若代码开始跑了,想提前中断的话,请使用ps aux 指令查看PID进程号了,并且使用kill -9 进程号 中断该进程并释放显存

一些常用终端指令

①rm -rf datasets/ ----删除datasets文件夹

②unzip dataset.zip ----解压dataset文件夹--xftp最好传输压缩包格式文件,这样快

③复制文件请在xftp中ctrl cv复制粘贴

本文链接:https://blog.runxinyun.com/post/350.html 转载需授权!

留言0