一、引言

在边缘计算场景中,资源往往相对有限,而 Kubernetes 作为容器编排的事实标准,其全功能版本在边缘设备上部署可能存在资源消耗过大等问题。K3s 作为轻量级的 Kubernetes 发行版,非常适合边缘计算环境,下面将详细介绍其部署实现与方法。

二、准备工作

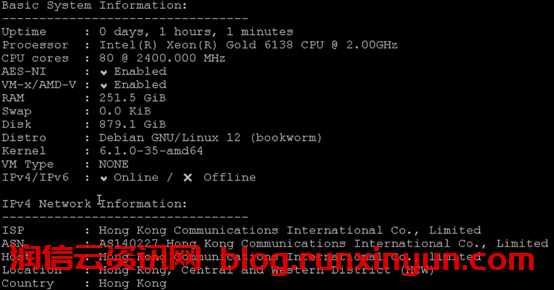

1. 硬件准备

准备若干边缘设备,确保它们满足基本的硬件要求。一般来说,设备至少需要有 1GB 以上的内存和一定的 CPU 计算能力。例如,常见的树莓派 4 系列就可以作为不错的边缘计算节点,其具备 4GB 或 8GB 内存选项,能较好地运行 K3s。

2. 软件准备

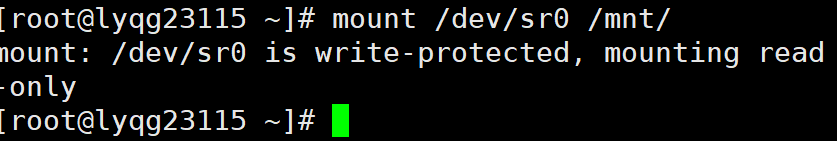

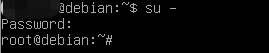

确保所有设备都安装了合适的操作系统,推荐使用 Linux 发行版,如 Ubuntu Server 或 Raspbian。同时,保证设备之间网络连通性良好,可通过 ping 命令测试。另外,为了后续的安全操作,建议开启 SSH 服务以便远程管理设备。

三、K3s 服务器端部署

1. 安装 K3s 服务器

在选定作为 K3s 控制平面的设备上,执行以下命令安装 K3s 服务器:

curl -sfL https://get.k3s.io | sh -这将自动下载并安装 K3s 服务器组件。安装完成后,K3s 服务会自动启动。

2. 获取集群配置文件

默认情况下,K3s 服务器的集群配置文件位于 /etc/rancher/k3s/k3s.yaml。为了方便后续在客户端使用,可将该文件复制到本地用户目录下,并根据实际情况修改其中的服务器地址:

sudo cp /etc/rancher/k3s/k3s.yaml ~/.kube/config

sudo chown $(id -u):$(id -g) ~/.kube/config四、K3s 客户端部署

1. 安装 K3s 代理

在边缘计算节点(客户端)上,执行以下命令安装 K3s 代理:

curl -sfL https://get.k3s.io | K3S_URL=https://<server - ip>:6443 K3S_TOKEN=<server - token> sh -其中 <server - ip> 是 K3s 服务器的 IP 地址,<server - token> 可以在 K3s 服务器的 /var/lib/rancher/k3s/server/node-token 文件中找到。

2. 验证节点加入

在 K3s 服务器上,使用以下命令查看已加入的节点:

kubectl get nodes如果客户端节点成功加入,将会在列表中显示其名称、状态等信息。

五、后续管理与优化

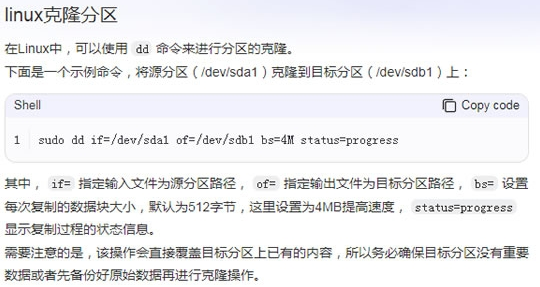

1. 应用部署

通过编写 Kubernetes 资源清单文件(如 Deployment、Service 等),使用 kubectl apply -f <filename.yaml> 命令在 K3s 集群中部署应用。例如,可以部署一个简单的 Nginx 应用进行测试。

2. 监控与日志

利用 K3s 集成的监控工具或第三方监控方案,如 Prometheus 和 Grafana 组合,对集群资源使用情况、应用性能等进行监控。同时,通过查看节点上的日志文件,如 /var/log/syslog 等,排查可能出现的问题。

通过以上步骤,我们可以在边缘计算环境中成功部署 K3s 集群,为在边缘设备上高效运行容器化应用提供了强大的支持。

本文链接:https://blog.runxinyun.com/post/943.html 转载需授权!

留言0